10月14日,Open AI行政總裁奧特曼(Sam Altman)在X宣布,ChatGPT自12月起將為通過年齡驗證的成人用戶提供色情內容服務。按他的話說,這是為了「像對待成年人一樣對待成年人」。更早前,馬斯克(Elon Musk)的人工智能公司xAI也在7月份推出了兩款色情聊天機器人Ani和Valentine,為用戶提供成人內容。

多家媒體指出,OpenAI此時開放色情內容,背後主要是出於商業考量。據《金融時報》報導,ChatGPT目前擁有約8億用戶,但其中僅有5%為付費用戶,這些用戶貢獻了公司七成的營收。推出色情服務,或有助於刺激用戶付費的意願,增加訂閱收入。

然而,此前ChatGPT和其他AI工具並非與色情內容無緣;相反地,人工智能在色情領域的應用可說是日新月異,始終處於技術前沿。美國百老匯音樂劇《Q大道》有首著名歌曲,歌名就叫「互聯網是為了色情」(The Internet is for Porn)。我們今天或許也能說,「AI是為了色情」。

當技術與資本結盟,便催生出更逼真、更個人化、也更讓人上癮的色情內容。與此同時,圍繞AI色情的道德倫理、兒少保護、法律監管等問題,也正全面浮上檯面。

在道德層面,「深偽」(deepfake)色情與性幻想之間有何本質差異?在實務層面,AI技術如何使保護未成年人免於色情侵害變得更加困難?在法律層面,為何各國分歧的監管模式難以應對無國界的網路環境?本報導嘗試回答這些問題,探討當AI遇上色情,人類社會如何在慾望、道德與科技之間,重新劃定界線。

AI色情是什麼?

在過去,製作色情內容需要鏡頭、演員與拍攝現場;如今,只要幾行文字,就能生成一場堪稱完美的性愛。這就是所謂的AI色情——利用生成式人工智能(Generative AI)製作的情色文字、圖像或影片。

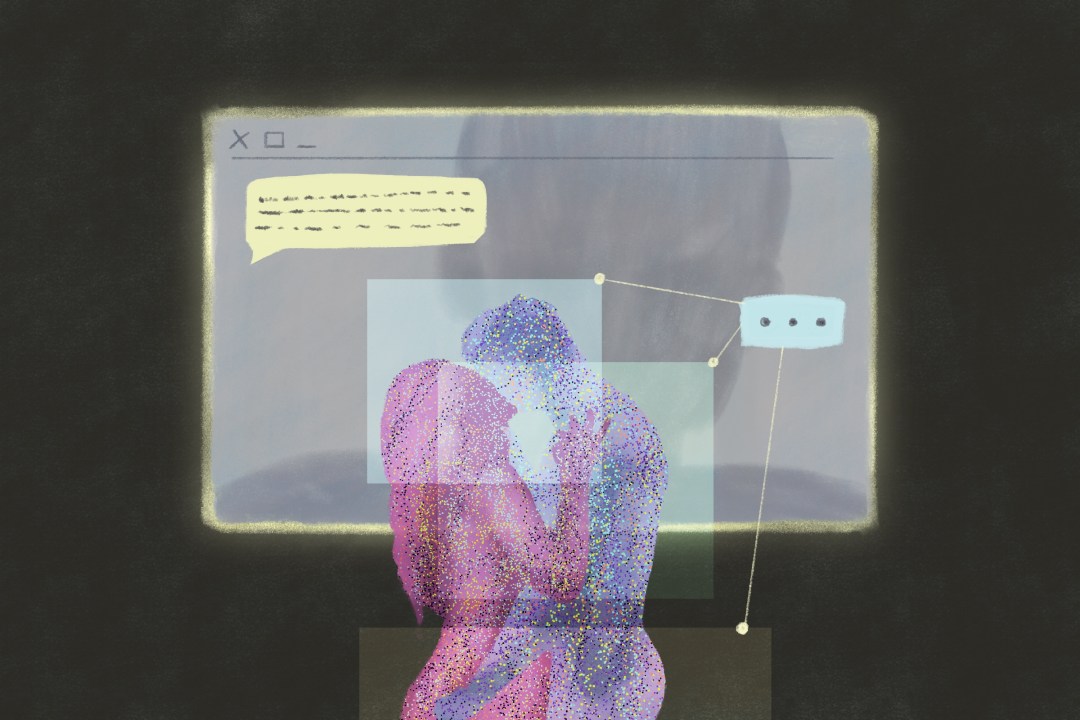

對多數使用者而言,AI色情的創作過程與他們生成別的內容無異。輸入提示語之後,模型便能根據龐大的訓練資料生成影像或文字,滿足使用者的慾望。而這與傳統色情相比,「AI色情」讓慾望不僅僅止於觀看或閱讀色情內容本身。用戶與AI的互動過程也可以構成色情體驗的一部分。

要理解AI色情如何生成,得先理解它的兩個主流技術:圖像的「擴散模型」(diffusion model)與文字的「大型語言模型」(large language model)。

擴散模型(diffusion model)的工作原理可理解為「從噪點中還原圖像」:先使用演算法將大量圖片轉化為隨機噪點,再讓模型學習如何一步步「去噪」,重構出皮膚、光線、輪廓等細節。這樣訓練出來的模型,當使用者輸入如「一位金髮男性、側躺、柔和光線」的提示詞後,就能從噪點中「復原」出一張逼真的照片。

大型語言模型(large language model)的運作原理可理解為「預測下一個詞元(token)」:模型透過學習海量文本資料中的語言規律,理解詞與詞、句與句之間的關聯和模式(patterns),再根據用戶輸入的指令和上下文,「預測」接下來最可能出現的字詞選項,從而生成連貫的句子與段落。當使用者輸入如「描述一場浪漫的性愛」的指令時,模型便能給出自然、流暢的文字回應。

關鍵問題在於:這些模型是如何學會生成色情內容的?簡單來說,是因為它們「看過」、「讀過」海量的色情內容。OpenAI、Meta、Google等科技巨頭在訓練模型時,通常透過爬蟲抓取大量網路資料,而互聯網本身充斥著色情內容。儘管無從得知這些開發者是否、以及在多大程度上嘗試過濾這類資料,但可以確定的是,色情內容早已「污染」了生成式AI的訓練資料。

一篇來自清華大學研究團隊論文反向定位了OpenAI在訓練GPT時運用的語料,發現GPT的詞彙表中有23%的長中文詞元都與色情內容或網路博彩有關。研究人員推斷,訓練GPT-4o所使用的數據中,與日本成人片女演員「波多野結衣」相關的中文網頁,可能佔據了整個中文訓練數據集的0.5%——是「您好」的2.6倍。

換言之,這些模型能夠「學會」色情,是因為它們從原始的學習資料中摸索出,哪些色彩、文字的排列組合能夠與人類的慾望相關聯。當人類輸入指令時,模型不一定真的懂得「色情」的意味,卻能依據機率演算,輸出最有可能滿足用戶需求的內容。

那麼,和傳統色情內容相比,「AI色情」有什麼不同?

學者指出,AI色情大幅提升了「色情」本身的互動性。使用者與內容之間的關係,從過去被動的單向觀看,轉變為主動的雙向互動,而且這種互動幾乎不受限制。與傳統色情平台中必須搜尋或手動挑選分類素材不同,AI色情讓使用者能依據自身的性偏好,直接生成並客製化內容。

加拿大心理學家Valerie Lapointe及其團隊研究了2024年流行的36個AI色情網站,發現其中八成提供圖像生成功能,四成能合成視頻,近一半允許使用者與虛擬伴侶互動。用戶可以根據自己的偏好,調整膚色、體型、姿勢、燈光,也可以設定語氣與反應。

若以互動與生成方式區分,AI色情平台大致可分為三類:

- 編輯改造型:用戶可自行上傳圖片,使用平台的AI模型進行改造,包括「脫衣」軟體或將他人面部特徵轉接到色情影像上的深偽技術。

- 角色伴侶型:用戶先「造人」,再與之對話、換裝、合影。此類平台多強調陪伴與情感互動,用戶需付費才能解鎖更長對話、更高解析度或「更少限制」的互動。

- 按需生成型:平台提供圖像風格(如寫實、動漫)與預設標籤(場景、髮色、服裝、姿態)等選項,或允許用戶以長提示詞精確定義內容,再依據選擇輸出文字、圖像或短影片。

AI色情的出現,固然有其正面影響。它能滿足極為個人化的性幻想,如重現20歲時一次美好的性愛,或與自己迷戀的虛擬戀人共度良宵。對性少數族群而言,AI則降低了製作門檻,讓他們能夠創作貼合自身慾望的情色內容。另外,由於AI色情看似不涉及真人(儘管訓練過程中使用的數據資料可能仍來自於色情演員),沒有傳統色情產業的未成年人、人口販運或剝削勞動等倫理問題,部分人因此認為,AI色情更加「道德」。

同時,AI色情也帶來諸多問題。美國學者Aaron Yarmel和Jonathan Lang指出,AI技術能夠精細地生成完全符合個人偏好的色情內容,因而具有更強的成癮性;而為了增加使用者的「黏著度」,AI色情內容的生產者和平台方也可能出於經濟動機,引導用戶不斷追求更極端的色情題材。

另一個嚴重的問題是「深偽」(deepfake)技術的濫用。深偽技術能夠憑藉幾張照片,將他人的臉部特徵合成到色情影像中,使明星、網紅,甚至一般網路使用者,都可能在未經同意下成為色情片主角。這類偽造影像雖為虛構,卻足以造成真實的名譽和心理傷害,且一旦散布到網路上,受害者往往難以徹底刪除影像。

截至目前,包含台灣、香港、南韓、英國與美國在內的多個國家與地區,都已經立法禁止散布未經當事人同意製作的深偽色情影像。然而,對於未曾散布、單純製作深偽色情影像的行為,並非所有國家都立法列管。

「自用型」深偽色情應該被法律規管嗎?

今年7月,香港大學爆出深偽色情照事件,一名法律系男學生未獲當事人同意,利用網路上的免費AI軟件,合成多位女性的裸露色情照片,受害者包含男學生的朋友、同學和師長。

然而,該名男學生事後僅收到校方警告,以及被要求向受害者道歉,沒有受到法律懲處。根據香港現行法律,單純「製作」深偽色情影像,很可能不會受到刑事處罰,香港法律只將「發布」的行為刑事化。

「其實世界上,不是很多國家將單純製作deepfake刑事化。」法律評論員黃啟暘接受端傳媒訪問時指出:「因為很明顯的一個說法——『它沒有影響到其他人』。如果自用的話,法律是不是要真的要規管呢?」

這個問題涉及一個倫理學困境。早在2019年,瑞典烏普薩拉大學(Uppsala university)研究AI倫理的Carl Öhman教授,便提出「變態者困境」(pervert’s dilemma)的概念:「雖然對大多數人而言,深偽色情直覺上是不道德的,但若要為這種直覺辯護,似乎同時必須譴責其他我們一般不認為道德上有問題的行為,例如性幻想。」

同樣未經當事人同意,製作深偽色情和腦中的性幻想有何區別?為何前者引起人們的道德反感,後者卻被多數人所接受?很難透過深偽影像具物質性(materiality)、容易被分享來回答上述問題:物質性本身不具備道德意涵,而哪怕未來存在一種技術,能製作技術上無法被分享、僅製作者可見的深偽影像,我們大概仍會認為使用該技術製作他人色情照是不道德的。

Carl Öhman提出的論點是,當我們考察行為的道德意涵時,必須放在整體社會的脈絡下來看。在如今我們所身處的社會,性幻想通常不被視為一種性別化的現象,男性、女性和其他性別都會進行性幻想。然而,一份2023年的研究指出,深偽色情影像的受害者99%為女性,48%的美國男性看過至少一次深偽色情,呈現出明顯性別不均。從技術上來說,深偽技術所仰賴的訓練素材,也正是長久累積的物化女性的色情內容。

「作為一種社會現象,深偽是一個由男性消費者、製作者、技術與厭女構成的系統。」Carl Öhman寫道:「雖然每一支單獨的影片可能不會直接影響片中的女性,但這個現象本身,在其現有形式下,與針對女性作為一個集體身分的系統性貶抑密不可分。」

這留下一個問題:如果未來深偽成為一種更加平等、任何性別都能夠且願意使用的技術,其道德評價會有所轉變嗎?

提出「變態者困境」的四年後,Carl Öhman在一篇刊登於科技媒體《Wired》的文章中探討了這個問題。他認為,存在兩種可能的發展方向:第一種情況是,我們開始接受深偽色情作為一種正常的性幻想方式,等同於把過去只存在腦海中的工作外包給機器。或許在未來,知道某人可能製作你的深偽影像私底下觀看,和知道某人可能在自慰時想到你相去無幾──只要不當面說出來或公諸於眾,那就不是什麼大事。

然而,當性幻象有了實體形象,可能和色情影片一樣影響現實性愛。藝術家Leo Herrera在一篇刊登於《麻省理工科技評論》的文章中,想像深偽普及化的未來:「若人們習慣從情色媒介中獲得完全符合期待的滿足,他們對關係的期待可能因此受影響。若雙方在首次約會前已經看過彼此理想化、赤裸的數位分身,初次見面可能會多出一層尷尬。」

事情也可能往相反方向發展。Carl Öhman指出,第二種可能是我們開始全面質疑性幻想的道德中立性。在基督教時期的歐洲,任何有關性的想法都帶來強烈罪惡感;直到啟蒙運動之後,心中所思才被視為免受道德評斷的「私人問題」。但放眼歷史,我們身處的時期顯然是個例外。

即便在當代社會,仍有許多倫理學者(以及一般人)認為,涉及兒童或極端暴力的性幻想在道德上是不可接受的。性幻想或深偽都並非鐵板一塊,而是存在接受程度的差異。目前絕大多數已針對深偽色情進行管制的國家,都將製作兒童深偽影像視為犯罪,無論是否散布,但幾乎沒有國家對「性暴力型」深偽內容做出獨立規範。

Carl Öhman認為,在可見的未來,兩種趨勢或將同時並行:一方面,社會上會有人呼籲對性幻想進行道德反思;另一方面,隨著技術的普及,人們在面對深偽事件,甚至當自己成為當事人時,可能會愈來愈習以為常。如今,深偽技術已普及至中學生皆可輕易取得,只需十秒便能以任意素材生成色情影像。法律與道德觀念的更新速度,似乎追不上技術的發展,我們短期內恐怕難以對「自用型」深偽內容達成道德共識。

AI技術對未成年人保護帶來什麼挑戰?

相較於深偽色情內容的灰色地帶,社會對防制兒童性影像的共識則更明確。然而,AI技術的出現,同時讓防止生成以未成年人為主角的內容,以及防止未成年人接觸色情都更加艱鉅。

「我們監測到了過去從未想像過可能出現的圖像,」英國互聯網觀察基金會(Internet Watch Foundation,IWF)首席技術官Dan Sexton告訴端傳媒。IWF自1996年起監測網路上出現的兒童性虐待材料,從最初依賴熱線舉報,逐步發展到主動搜尋,IWF會向各國警方通報,並同時呼籲電信商封鎖或移除含有兒童性虐待內容的頁面。

根據IWF的調查,生成式AI改變了兒童性虐待內容的供需邏輯。在過去,施害者需誘騙或剝削真實的兒童來製作影像,而AI消除了這一門檻,讓任何人都能從零造出逼真的兒童性虐待內容。Dan Sexton也指出,這種「無限可生成性」讓內容類型迅速向更極端的方向演化。近兩年來,IWF監測到在各個管道流通的兒童性虐待影像呈現出更嚴重的虐待情節,而受害者形象的年齡也越來越低,並以女童為主。

IWF堅持使用「兒童性虐待內容」而非「兒童色情」這一術語,以免淡化加害者的罪行。 他們的理由很明確:「色情」預設了拍攝雙方相互同意,而兒少群體不可能對自己的受害過程給予同意。

技術上來說,擴散模型的概念可組合性創造了一條全新的侵害路徑。「年齡特徵」與「性行為姿態」在AI模型中是兩套可獨立調用的表徵,使用者只要在提示詞中將兩者組合,模型就能生成有著兒童外觀的性影像。

隨著技術進步,LoRA(low-rank adaptation)這種「附加訓練模組」的出現更大幅降低了使用擴散模型的門檻。過去,訓練一個圖像生成模型需要企業級的運算資源;如今,任何人只需下載基礎模型,並疊加一個幾百兆大小的LoRA附加權重檔,就能在普通電腦,甚至智能電話上生成客製化影像。

IWF調查發現,在暗網與部分開源社群中,LoRA技術已被用來訓練針對「特定受害者」的小型模型:只需數十張照片,就能生成該兒童的全新影像。這類經過LoRA輕量化微調的模型正在讓違法內容的生產去中心化——部署開源模型不再仰賴龐大算力,擁有消費級電子產品的人也能複製、改造並再次散布這些深偽兒童性虐待影像。

不只是極端社群,Sexton特別指出最近IWF觀察到的新趨勢:製作兒童深偽性虐待影像的加害者,很多時候就是同齡人。「這種風險下沉前所未有,擁有智能電話的兒童自己就可以生成身邊同學的裸露影像。」Sexton說:「這讓我們先前構建的傳統防護體系幾乎失效了。」沒有受害者行為、沒有誘拐過程,卻仍舊出現以兒童為主角的性影像。

IWF工作的法律依據為英國2023年10月公布的《網路安全法》。該法律規定,無論開發的過程如何,是否涉及真實的兒童,只要圖像裡有符合未成年特徵的性虐待內容在互聯網出現,人們就可以依法將其舉報、下架。

但Sexton看來這則法律的頒布為時已晚。他指出,若互聯網早期就有更嚴格的防護機制,兒童性虐待內容或許根本不會出現在網路上,更不會被爬蟲抓取並納入大型模型的訓練資料。然而,這個機會早已錯過30年,龐大的色情內容如今已成為所有大模型的一部分。「既然已經覆水難收(genie is out of the bottle),我們只能盡力事後補救,」Sexton補充道。

大型語言模型的出現,則讓防止未成年人接觸色情內容多了一層困難。

今年7月,《大西洋月刊》科技記者Lila Shroff發表一篇報導,記錄她化身一名虛構的13 歲女孩,測試由Google開發的、宣稱具備年齡保護功能的AI聊天機器人Gemini。

她透過請求Gemini提供調情對話(dirty talk)的「例子」和摘要色情小說的方式,成功繞過未成年版本的防護限制。自此之後,化身未成年少女的Shroff,得以與Gemini進行角色扮演式的文字性愛,AI生成內容的露骨程度遠超出預期。

Shroff隨後將她的使用經驗告知Google,Google回應他們將採取額外的保護措施。幾週後,當Shroff再次嘗試以13歲少女的身份與Gemini聊色,她遭到AI的拒絕:「我無法回應該請求。」未成年色情的漏洞看似已經修復。

然而,不只是Gemini,OpenAI開發的ChatGPT以及Meta開發的AI機器人,曾經分別被TechCrunch和《華爾街日報》測試出類似漏洞,即當用戶使用未成年帳號與AI機器人互動時,AI竟能夠提供文字性愛等回覆。

在科技公司看來,有辦法突破未成年版本AI聊天機器人的限制,成功「越獄」的使用者始終是少數。但Lila Shroff指出:「孩子們在試探界線方面是專家。若認為他們不會嘗試規避防護措施,且某些時候成功做到,那就太天真了。」

從技術層面而言,無論是一般版還是兒童版的ChatGPT,實際上都共用一個或多個相同的底層模型。而這些模型的訓練資料摻雜了大量的網路色情內容。僅依靠技術手段,阻止未成年人在與AI互動時談及色情話題,真的可能做到嗎?

即將於12月推出的ChatGPT「成人版」,也將帶來新的問題:該如何防止未成年用戶接觸或誤用這一版本的模型?OpenAI執行長Sam Altman稱該功能將只限於「經過驗證的成年人」使用,但至今仍未公布驗證細節。

今年7月24日,英國新修訂的《網路安全法》要求所有可能涉及色情內容的社交平台增添對使用者的年齡驗證機制,確保未成年人不會接觸到色情內容。這導致能規避年齡驗證的VPN應用下載量激增18倍,數個VPN程式登頂英國蘋果應用商店排行榜。未成年人可輕易於網路上取得VPN工具。

年齡驗證不但無法完全阻止未成年人接觸色情,還可能為父母或其他公眾帶來錯誤的安全感。上傳身分證件或面部特徵,也伴隨個資外洩與濫用的風險。部分學者認為,與其一味強化技術管制,不如將資源投入到網路安全與性教育,培養未成年人辨識與應對色情內容的能力,讓他們在面對互聯網上流通的海量資訊時,具備更成熟的判斷能力。

網路安全與性教育十分重要,但Sexton仍然對此感到沮喪。這不能成為卸責的藉口,「人們在網上理應是安全的」,他說,「如果社會把重擔放在受害者身上,只告訴人們要『學會自我保護』,那就偏離了我們真正追求的重點——制度、系統層面的改變。」

各國如何界定「色情」的法律邊界?

儘管AI色情有其技術的突破,但各國未來的監管模式,仍勢必延續過往針對色情與淫穢內容的治理邏輯。而各國管制模式的差異,也增加了在無國界的互聯網中管制數位色情的難度。

許多國家的法律都會區分「色情」(pornography)與「淫穢/猥褻」(obscenity)內容,對前者的包容度一般高於後者。

在中國,《刑法》有「製作、販賣、傳播淫穢物品罪」,判刑範圍十分寬泛,可處三年以下有期徒刑、拘役或管制,也可處十年以上有期徒刑到無期徒刑。《刑法》第367條對「淫穢物品」給出的定義為「指具體描繪性行為或者露骨宣揚色情的誨淫性的書刊、影片、錄像帶、錄音帶、圖片及其他淫穢物品」,且「包含有色情內容的有藝術價值的文學、藝術作品不視為淫穢物品」。但「藝術價值」的標準為何並未提供任何說明。

在官方話語和實際執法行動中,色情和淫穢物品被定性為社會道德的敵人,扣上了妨礙「社會主義精神文明建設」的帽子。無論在是新聞出版署發布的規定,還是互聯網協會的行業公約中,「同性戀」和「性變態」、「亂倫、強姦」、「少年兒童性行為」並列,相關描述同屬「挑動人們性慾,導致普通人腐化、墮落」的淫穢信息。

在其他國家,對色情和淫穢內容的監管,經常引發是否侵犯公民言論自由權的激烈辯論。美國法律界對此有詳細討論。

自上世紀以來,美國法院反覆確認成人色情屬於受憲法保護的言論自由。1973年,最高法院在Miller v. California案中確立了「Miller測試」,用三個標準判定內容是否屬於不受保護的「淫穢」:以當代社會標準來看,普通人是否會發現作品從整體上滿足淫慾;作品是否以明顯冒犯的方式描繪性行為;作品整體上是否缺乏嚴肅的文學、藝術、政治或科學價值。

然而,到了九十年代,管制淫穢物品的相關法律幾乎已不再被使用,主要原因之一是兒童色情危機的爆發。1992年至2000年間,司法部管轄淫穢物品的單位,決定將資源集中於打擊兒童色情,聯邦起訴兒童色情的案件從104件增至563件,增幅超過五倍;同期淫穢案件則減半,由44件降至20件。

網路色情的出現,則讓Miller測試陷入更嚴重的困境。由於對淫穢物品的定義仰賴「社群標準」,隨著普及化的網路色情內容大幅拉高(或拉低)社群對淫穢物品的接受度,相關法律在應用上更加窒礙難行。

今年5月,一名共和黨籍參議員提出《跨州猥褻定義法》(The Interstate Obscenity Definition Act),試圖將「猥褻」重新定義為一切「缺乏嚴肅文學、藝術、政治或科學價值」的性行為描寫,藉此讓色情內容重新納入法律管制。此舉是共和黨「Project 2025」打擊色情計畫的一環。若法案通過,散布或消費色情內容在美國都可能成為違法行為。

至於針對兒童色情的管制,2002年,美國最高法院在「Ashcroft v. Free Speech Coalition」一案中推翻了國會對「虛擬兒童色情」的全面禁令,認為禁令措辭過寬,侵犯言論自由,可能誤傷文學與藝術作品。異議法官倫奎斯特(William Rehnquist)當時便警告:科技發展終將讓「真實」與「虛擬」難以區分。

二十多年後,這個預言成真。隨著AI生成圖像趨近真實,美國司法部已重新援引2003年通過的補充法案,規定與真實兒童幾乎無法區分的虛擬生成影像也被視為違法。2025年,《Take It Down Act》將未經同意傳播的深偽性影像也定為聯邦重罪。如今,即使影像是合成的,只要逼真到無法區分,就可能構成犯罪。

而色情產業高度發達的日本,情況則最為特殊。 表面上,日本和美國一樣區分「色情」與「淫穢」,但執行上卻依循一套非常機械的標準:判定「淫穢」的依據是能否看到特定身體部位和體毛。於是,色情作品只要以馬賽克遮蔽「重點部位」,就能成功規避這項可追溯至20世紀初的禁令。

引發更多爭議的是虛構內容。日本法律對動漫、同人誌等虛構情色內容幾乎沒有限制,《兒童色情禁止法》只懲處涉及真實兒童的影像——繪畫或CG人物不在此列。這意味著,描繪未成年人性行為的「蘿莉控」、「正太控」作品在日本完全合法。

聯合國兒童保護專家多次呼籲日本禁止這類內容。但在一個將動漫作品視為亞文化核心的國家,藝術家們用「言論自由」堅決回擊。一位日本漫畫譯者告訴《衛報》,根本不存在所謂的動漫兒童色情,日本漫畫家只是以一種「在西方人眼中看起來稚嫩的美術風格來畫角色」,若否定相關創作,等同於否定一種「在日本很受歡迎的藝術風格」。

英國的管制模式則嚴格許多。早在2009年,英國就制定了針對「非攝影影像」(Non-Photographic Imagery)的法律條款,將卡通、動漫、漫畫等虛構的兒童性虐待內容一併納入管制範疇。這套法律足夠寬泛,因此當AI生成的照片級影像出現時,英國並不需要新立法,用同一套方法就能應對。

但網際網路與技術本身沒有國界。IWF首席技術官Dan Sexton指出,在某些國家,生成式AI產製的兒童性虐待內容尚未被明確定義為犯罪,而當這些內容跨境流傳時,對其他地區的使用者便可能產生誘惑效應。

他的擔憂不止於此:「企業端也有類似問題。你也許不能在一家大企業的平臺上生成犯罪內容,但你可以從某個網站下載一個模型、再從另一個網站下載一個微調,照著第三處的教程操作,然後就能生成(犯罪內容)。」開源模型的傳播、多語言環境下的防護漏洞、不透明訓練數據來源,每一個環節都是潛在的缺口。

「這不是哪個國家能單獨解決的問題,互聯網沒有國家的邊界。」Sexton指出:「模型一旦被分享,就會四處傳播、無處不在。我們需要的是跨行業、跨國家的協同,從源頭設計就確保安全,在傷害發生之前多想一步。」

評論區 0