“算法”真的冷酷而准确吗?事实证明,它也许能摒除人类的主观情感,但机器学习系统所吸收的数据和知识却来源于人类,包括人的偏见。由人类创造的人工智能,目前还摆脱不了人性局限的阴影。他们学习了知识,却无法摒弃认知偏见。

不少案例显示,人工智能(Artificial Intelligence ,简称AI)如果存在歧视倾向,会严重影响人们的生活。一名22岁的亚裔DJ在申请新西兰护照时遭拒,原因是他眼睛较小,处理照片的系统自行认定他“双眼闭上”,不符合相片要求。微软开发的聊天机器人Tay 在上线24小时后,就开始发表“希特勒没有做错事”等种族主义言论。有研究曾指出,Google在第三方网站上的广告中,向男性求职者展示的招聘广告待遇普遍比女性求职者高。哈佛大学肯尼迪学院发布的分析报告也指出,目前针对犯罪倾向性预测的人工智能系统对黑人群体存在偏见,而这种对人种肤色的偏见无法通过调整机器学习的策略和算法得以解决。

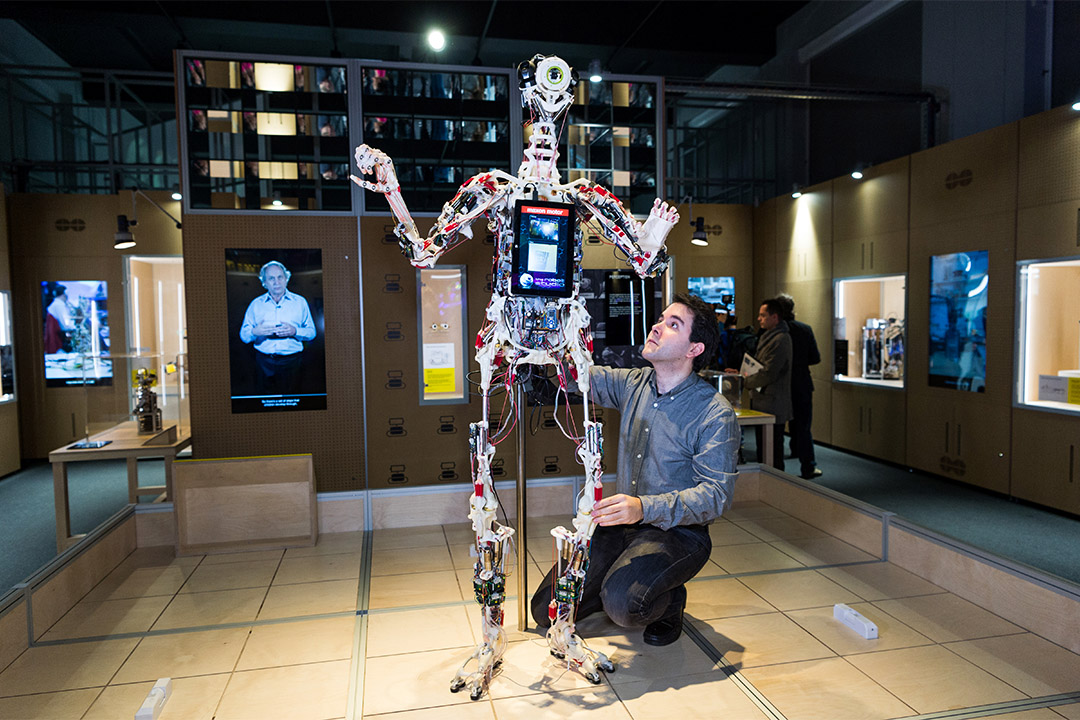

机器学习

这也是为什么人工智能仍处于发展“幼年期”,就已经有提倡人工智能监管的声音出现。

2016年4月,欧洲议会通过了商讨四年的《一般数据保护条例》(General Data Protection Regulation),条例中提到的“解释权”将赋予欧盟国家公民“审查某项特定服务中如何做出特定算法决策”这一权利。这一条例将于2018年正式执行,应用范围包括脱欧进行中的英国。

伦敦阿兰·图灵研究所(Alan Turing Institute)和牛津大学互联网研究所的研究团队却发布报告指出,《一般数据保护条例》没有从根本上保证人工智能的问责和透明度。报告作者之一桑德拉·瓦赫特(Sandra Wachter)在接受端传媒专访时表示,这份条例只能给予人们最低限度的保护,对“解释权”没有足够的法律约束力。特别是其中涉及“解释权”的措辞,只保障了人们对某一人工智能决定进行质疑、介入的权利,没有要求企业向人们解释某一人工智能决定可能导致的后果,从而削弱了“解释权”应有的作用。

人工智能之所以作出有偏见的决定,瓦赫特认为是源于系统固有的不透明性。“这一问题的根源有两方面,一方面,算法从获得的数据中分析并寻找模式,得出的结论是开放者无法预测的,另一方面,输入算法中的数据可能存在偏见,因此导致算法得出有偏见的结论。”她举例道:

“我的公司想招聘一个管理职位,为了找到最好的人选,我会把过往成功申请者的数据输入到算法中。我或许不知道具体选拔标准,但算法能在数据中得出某些模式,例如,这一职位的人选通常是中欧的40岁白人男性。因此,数据和结论都是存在偏见的。”

她认为,在一些社会领域,人工智能在作出公正、公平的决定上有着巨大潜力,例如医疗卫生方面,人工智能可以在临床试验上检测到人类无法察觉的临床表征,但同时,在劳工市场、司法系统等方面,人工智能的风险可能会带来影响绝大多数人的严重后果,因此在运用时应该更加谨慎。这也是为什么她认为现时就应有对于人工智能监管的多方面讨论,只有社会上有了相关道德准则和深谋远虑之后,人工智能才能被更好地被塑造,在人类社会发展中发挥正面作用。

研究所另一份报告比较了在2016年10月,白宫、欧洲议会和英国下议院各自发表的关于社会如何应对人工智能广泛使用的白皮书。三份白皮书都认为,透明度、问责和对经济及社会的积极作用,是衡量“良好的人工智能社会”的指标,并特别点明了人工智能对经济、教育、战争、多元化、国家安全等方面的影响。

但报告指出,三份白皮书都忽略了一个重要的问题——对于在21世纪的成熟信息社会,人类应该有什么样的规划?报告建议,人类应清晰认识我们想要发展的“良好人工智能社会”是什么样的,并引导人工智能向对人类有益的方向发展。在这其中,政府有责任制定法规监管人工智能,问责人工智能作出的决定,这一责任是企业和研究界无法替代的。

微软创始人比尔·盖茨也认同政府在监管机器人发展中的积极角色。他认为,在将来,政府将会就智能化推出相应的税项,而特别是在解决机器人取代人类劳动力所带来的不公平问题上,政府比商界能起到更大的作用。他还提出,如果机器人将大范围取代人类工作岗位,那它们应为此买单。他说,人类工人需要缴纳所得税、社会保障税等,如果机器人在工厂做与人类工人同样的事情,机器人也应按同等水平缴税。

瓦赫特还指出,应建立一个值得信赖的第三方监管机构,对人们认为受到歧视的人工智能决定进行调查,对有关算法进行审计,这既能消除企业对商业机密外泄的担忧,同时也能让当事人对结果感到满意。她表示,对于人工智能的监管应该是一个全球性的议题,如何塑造科学技术在人类社会的角色,需要有政府、学界、私营企业及公民社会的参与和讨论。

值得一提的是,在今年2月“Beneficial A.I. 2017”大会后,霍金、马斯克(Elon Musk)等892名人工智能或机器人研究人员和1445名专家联名支持并发布了《艾斯罗马人工智能23原则》(Asilomar A.I. Principles),订下人工智能应该在生产力、道德和安全领域遵守的23条基本原则。原则中就提到司法透明度,指出,在司法决策系统中使用任何形式的自动化系统,都应提供令人满意的解释,并由有能力的人员进行审查。

不过,也有学者认为在现阶段就引入人工智能监管是不成熟的。著有《超级智能》(Superintelligence)的牛津大学哲学教授尼克·波斯特罗姆(Nick Bostrom)对端传媒表示,虽然在部分领域智能技术已有超越人类的表现,但广泛来说,人工智能的发展还未达到与人类相当的水平。

但波斯特罗姆也预测,人工智能一旦可与人类水平比肩,可能会在不到10年时间里向超级智能的方向发展。他认为,正如我们的肌肉在力量和耐力方面已被机械装置所超越,即便生物医学有突破性发展,我们的大脑最终也将会被机器超越。

如此说来,尽早在人工智能立法上绸缪,或许是人们步入“良好人工智能社会”的正确方式。

所謂的機器偏見,不過是人性的影子。

監管機器不如監管人類。

人類會被機器人淘汰,其實指的只是「目前的人類」而已。因爲今天的大多數人活得就像機器一樣,按照機器的運作方式去工作,按照機器式的簡單邏輯去思考,沒有發揮出人類本有的價值和潛能。

端百科有誤:「深度學習」只是機器學習的一種常用方法,或者說一個分支。

哪里有什么偏见,这只是极端的客观和理性。

开放蠕虫都不能完全模拟一只真正的蠕虫,更何况是复杂的人脑。若想实现科幻片中的高级AI为时太早,现存的偏见其来源还是人类。全球范围能够达成对民主、自由、人权、平等的共识,人类文明就会很自然的过渡和进阶。